Création et IA : un point sur les algorithmes de génération d’images par Christophe Martin

Directeur de création technophile, Christophe accompagne les agences dans l’intégration de l’IA dans leur processus de création et de production. Sans langue de bois, il partage ici sa vision et ses pratiques et nous explique pourquoi c’est utile de se former à Midjourney ou Runway !

Entre agences, start-up ou cabinets de conseil, j’évolue dans la communication et le digital depuis 20 ans. J’ai notamment été directeur de création chez Marcel et Leo Burnett (Groupe Publicis) et je suis indépendant depuis quelques années. Je travaille principalement pour des agences et des boîtes de prod dans le domaine de la création visuelle. Comme j’ai toujours eu une appétence pour les nouvelles technologies, j’aime défricher des territoires émergents. Depuis quelques années maintenant, je m’intéresse particulièrement aux algorithmes d’intelligence artificielle.

Je travaille de plus en plus dans la production et de moins en moins en rough, en storyboard ou en conception. Mon gros sujet du moment, c’est d’accompagner des agences dans l’intégration de l’intelligence artificielle dans leur processus de création et de production.

Le brief était assez clair : on devait, en phase avec la promesse du magazine, immerger la cible dans un univers artistique. Des fleurs de lys, à l’architecture, en passant par la lumière, le style, ou encore certaines textures ou traits, les visuels reprennent volontairement des éléments iconiques des œuvres de Tamara de Lempicka, Edward Hopper et John James Audubon qui sont en couverture du magazine. Pour produire ces visuels j’ai utilisé Midjourney, différents outils de l’écosystème Stable Diffusion et Magnific.ai. Cette campagne, une des premières où l’IA est utilisée en production, est déployée en affichage, en presse et en digital. Indirectement, cette campagne interroge également le sujet du plagiat des artistes et de l’entraînement des IA.

Oui, on peut citer la campagne Masterpiece qui a été faite par Coca Cola. C’est un spot TV assez intéressant car il mixe de l’intelligence artificielle et des moyens plus traditionnels comme de la 3D. Pourquoi elle est intéressante ? Parce que l’IA n’est pas utilisée comme un moyen de diminuer les coûts de production, mais comme un outil avec ses propres spécificités.

C’est une formation très axée sur la pratique qui s’adresse à des graphistes / DA qui n’utilisent pas encore, ou très modestement, Midjourney. En 1 journée, les apprenants découvrent et expérimentent les fonctionnalités principales pour créer des images ou modifier des visuels existants.

Par exemple, parce qu’il y a de fortes chances qu’on te demande de faire de la conception et que toute la phase de recherche de visuels – qui se faisait sur les banques d’images ou via Internet – ne se fera plus jamais comme avant. L’intelligence artificielle permet de matérialiser des idées rapidement et dans une forme qui est plus attrayante qu’avant. Pour la création d’un mood board, d’un visuel clé ou d’un storyboard, l’IA te change la vie.

Je réponds que ce n’est qu’un outil et que, de toute manière, c’est toujours l’intention qui prime… Ce n’est pas parce qu’il y a eu Fiverr, et donc des gens qui font des maquettes pour 20€, que le marché a connu une révolution. Je ne crois pas que les clients qui font appel à une agence pour une campagne de pub vont changer leur fusil d’épaule. La création et la production sont le résultat d’une pensée stratégique. Ça n’aurait pas vraiment de sens de confier sa création à quelqu’un qui n’aurait qu’une appréhension technique des solutions d’IA. Tout est intimement lié à la culture des équipes créatives.

Oui, et je suis partagé. Je pense qu’ils ont malheureusement l’avantage et l’inconvénient d’être ce qu’ils sont : 1 des plus gros acteurs mondiaux du software. Avoir cet outil dans Photoshop, c’est très bien parce que c’est une première clé d’entrée dans l’IA pour les graphistes. C’est très utile et efficace pour des retouches simples par exemple. En revanche, pour concevoir des visuels de manière professionnelle, je ne pense pas que ce soit, aujourd’hui, un outil adapté.

Pour moi, c’est un outil grand public. Avec DALL•E 3, quand on sort des images, on est souvent dans un truc très standardisé avec une esthétique peu différenciante. Si on l’utilise par défaut, un peu comme Midjourney d’ailleurs, on ne sortira pas du lot. Il faut les « débrider » pour sortir du goût commun car, sinon, on est souvent dans une esthétique très américanisée.

C’est un outil relativement simple pour générer des séquences vidéo et ça me semble parfaitement complémentaire de Midjourney dans un processus de conception. Certes, on ne va pas utiliser Runway pour produire des films. Mais pour produire des animatiques, des mood board vidéo ou du contenu social media, c’est complètement adapté.

Je ne le crois pas. Midjourney et Runway sont des outils que l’on peut qualifier « d’établis ». Les fondamentaux financiers de leurs éditeurs sont solides et leur ergonomie suffisamment stable pour être utilisée par des entreprises et des agences. C’est vrai qu’aujourd’hui, si tu te balades sur les réseaux sociaux, tu as l’impression qu’il y a tous les jours un nouvel outil génial. C’est évidemment faux ! Avec Midjourney ou Runway, tu as 2 solutions qui me semblent pérennes et de bonne qualité.

Les possibilités folles offertes par les outils. Souvent, j’entends des phrases du type « Ah, on peut faire tout ça avec Midjourney, c’est absolument dingue ! ». Surtout je pense que cela provoque une forme d’étincelle ou de feu créatif qui est parfois un peu éteint ou au moins abîmé par le quotidien.

La gestion des détails et les problèmes de cohérence. D’où l’arrivée de fonctionnalités comme “–sref” (homogénéité graphique) ou “–cref” (cohérence dans les visages) dans Midjourney qui nous apportent cette continuité. Ces nouvelles fonctions vont nous faire gagner un temps considérable.

Tout se passe sur X (anciennement Twitter) et Reddit. C’est ici que l’on va trouver les experts et les informations les plus pointues sur les aspects technologiques ou sur les phénomènes émergents.

Ce qui risque de faire le plus parler, c’est évidemment l’arrivée de GPT-5. Ensuite, je pense que la vidéo va connaître une évolution similaire à la génération d’images. Quand on voit la différence qu’il peut y avoir entre Midjourney 1, sorti en mars 2021, et la V6 aujourd’hui, la progression est hallucinante. Je suis à peu près sûr que la vidéo va suivre le même chemin. On peut imaginer par exemple que SORA nous propose rapidement de générer des séquences vidéo d’1 ou 2 minutes pour quelques euros. Enfin, dans un futur proche, la génération 3D devrait bien être secouée également. Il y a plein d’outils à fort potentiel. Reste à voir lesquels sortiront du lot et s’imposeront comme des standards !

Des outils fonctionnant uniquement en local, comme Chat with RTX de NVidia (pour la conception), commencent à apparaître. C’est intéressant car la confidentialité est un point important lors des phases stratégiques.

Pour génération d’images, on peut citer Krea.ai qui permet par exemple de « dessiner » avec des primitives et générer des images qui sont guidées par ces primitives.

Enfin, pour la vidéo, beaucoup de choses émergent dans l’écosystème open source de Stable Diffusion. Ces outils sont aujourd’hui assez peu adaptés aux agences mais ils offrent une ouverture sur les possibilités de demain.

À lire sur notre blog

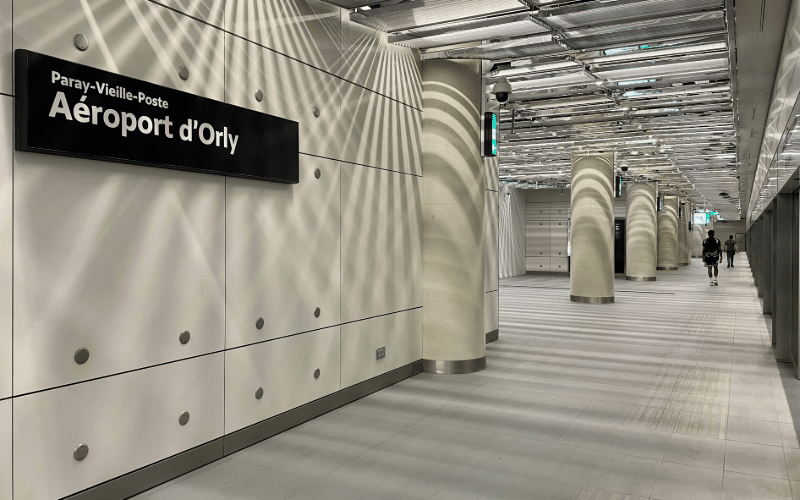

Signalétique, héritage et authorship : ce que le débat sur Parisine révèle

La newsletter de Swash

Nous vous recommandons ces formations

Midjourney : affûter son art du prompt pour professionnaliser sa pratique

1 journée

|

Génération de vidéos et animation d’images avec RunwayML

2 jours

|

14 heures

Midjourney, Firefly… Générer des visuels à l’aide des algorithmes d’IA

1 journée

|